“MS 다이렉트엑스가 키운 엔비디아...파이토치 2.0과 성장할 리벨리온”

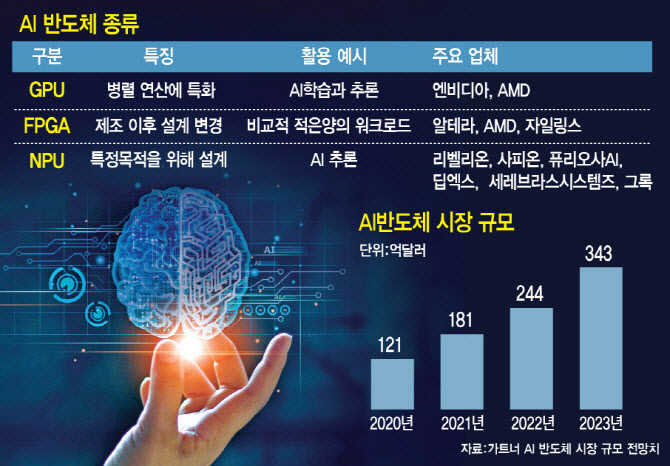

김홍석 리벨리온 최고 소프트웨어 아키텍트(CSA·Chief Software Architect)는 지난 7일 이데일리와의 단독 인터뷰에서 토종 신경망처리장치(NPU) 강자로서 리벨리온의 미래에 ‘파이토치 2.0’이 가지는 의미를 이렇게 설명했다.

‘파이토치’는 딥러닝을 구현하기 위한 파이썬 기반 오픈소스 머신러닝 라이브러리로, 지난해 3월 AI 훈련 및 추론 성능을 크게 향상시킨 2.0 버전이 공개됐다.

이 라이브러리를 통해 파이토치 커뮤니티의 개발자들은 자연스럽게 리벨리온 AI 반도체를 활용해 AI를 개발할 수 있게 된다.

이는 MS가 그래픽스 응용프로그램인터페이스(API)인 다이렉트엑스를 내놓았을 때, 엔비디아가 이에 맞춰 그래픽처리장치(GPU)를 발전시킨 것과 유사한 개념이다.

김 CSA는 “어찌 보면 엔비디아의 GPU는 MS가 이끄는 방향에 맞춰 함께 성장한 측면이 있다. 리벨리온이 AI 칩에 ‘파이토치 2.0’을 도입하려는 것도 같은 이유”라고 설명했다.

|

리벨리온은 국내 신경망처리장치(NPU) 업체 중에서 가장 빠르게 제품을 출시하고 상용화에 성공했으며, 기업가치 9000억 원을 인정받는 등 높은 평가를 받고 있다. 그러나 그동안 최종 고객인 ‘AI 엔지니어’의 개발 편의성을 높이는 노력은 상대적으로 덜 알려져 있었다.

리벨리온은 이번 주 SK그룹의 사피온코리아와의 합병을 공식 발표할 예정이며, 합병법인의 대표는 박성현 리벨리온 대표가 맡게 된다. 또한, 개발 조직은 오진욱 CTO와 김홍석 CSA가 주도할 예정이다. 이로 인해 리벨리온의 AI 반도체 소프트웨어 생태계 전략에 대한 관심이 더욱 집중되고 있다.

“스타트업 합류 이유 중 하나도 파이토치 2.0 덕분”

AI 반도체에서 소프트웨어 생태계가 중요한 이유는 네이버, 인텔, KAIST가 협력해 ‘AI 공동연구센터’를 설립하고 AI 반도체의 최적 구동을 위한 오픈소스 첨단 소프트웨어를 개발 중인 사례만 봐도 잘 알 수 있다. 아무리 뛰어난 AI 칩이라도 개발자들이 사용하기 불편하다면 대중화되기 어렵기 때문이다.

김홍석 리벨리온 CSA는 “파이토치는 메타(옛 페이스북)가 개발한 라이브러리인데, 2.0 버전이 되면서 파이토치로 작성된 머신러닝 모델을 실제 반도체에서 최적화된 성능으로 구동할 수 있게 됐다”면서 “엔비디아, AMD 등 빅테크 기업들도 자사 칩에 이를 지원하려 한다”고 말했다.

김홍석 CSA가 스타트업 리벨리온에 합류한 것도 ‘파이토치 2.0’ 덕분이었다고 한다. 그는 “파이토치 2.0이 나오면서, 이제 스타트업에서 다시 시작해도 되겠다는 생각이 들었다”고 밝혔다.

미국 출장 중인 박성현 리벨리온 대표도 “미국에서는 이제 파이토치 2.0이 주요 화두인데, 한국은 여전히 쿠다(CUDA) 이야기만 하고 있어서 아쉽다”고 전했다.

|

이달 중순 첫 결과물…“파이토치 생태계와 완벽 통합될 것”

김홍석 CSA는 “파이토치 2.0을 적용한 첫 결과물이 8월 중순 발표될 예정”이라며, 세 가지 단계로 설명했다.

첫번 째 단계는 리벨리온 반도체에서 최적화된 모델을 ‘토치컴파일(torch compile)’이라는 API로 전환해 배포하는 것이다. 두번 째는 파이토치 2.0 위에 거대언어모델(LLM) 추론 최적화 솔루션을 만들어 제공하는 것이며, 셋번 째는 전 세계 모든 사용자가 파이토치 2.0을 설치하면 리벨리온의 AI 반도체가 기본적으로 지원되도록 하는 것이라고 했다. 김 CSA는 “이 목표들이 달성되면 리벨리온은 파이토치 생태계에 완벽히 통합될 것”이라고 언급했다.

|

AI 인프라 혁신을 이끄는 vLLM…업스테이지와 성공

김홍석 리벨리온 최고 소프트웨어 아키텍트(CSA)가 주목하는 또 다른 기술은 ‘다재다능한 거대언어모델(vLLM, Versatile Large Language Models)’이다. 현재 글로벌 AI 생태계는 AI 인프라 비용(칩, 클라우드, 데이터센터 등)으로 인해 큰 부담을 겪고 있다.

이러한 상황에서 vLLM은 효율적인 추론과 서비스를 위해 설계된 라이브러리로, 리벨리온이 개발 중인 추론용 AI 칩에 새로운 가능성을 제시하고 있다.

vLLM의 작동 원리를 살펴보면, 생성형 AI는 명령어 입력 시 최종 답변을 생성하기 위해 모델을 반복적으로 포워딩(학습)하는 과정에서 KV(Key-Value) 캐시를 생성한다. 그러나 vLLM을 사용하면 매번 새로운 KV 캐시를 만들지 않아도 된다.

그는“모든 데이터를 처음부터 복귀하고 반복하는 것은 많은 비용과 시간이 소모된다. 하지만 KV 값을 계산해 이를 재활용하면 속도가 크게 향상된다. 이를 통해 새로운 토큰을 생성할 때마다 메모리에서 데이터를 다시 불러오는 과정을 생략할 수 있다. 이 과정에서 배칭(batching) 기술도 사용되며, 이를 통해 처리 속도를 높이고 비용을 절감할 수 있다”고 설명했다.

또한, 그는 “이 기술은 서울대학교 전병곤 교수님(프렌들리AI 대표)이 처음 논문으로 제시했고, 연속 배칭(Iteration Batching) 기술을 활용한 솔루션도 출시됐다”고 덧붙였다. 이 기술은 클라우드와 같은 시스템 인프라가 더욱 효율적으로 AI 작업을 수행할 수 있도록 최적화된 소프트웨어 기술이며, 다수의 이용자가 AI 모델에 요청을 보냈을 때 이를 효율적으로 묶어 처리한다.

리벨리온은 이러한 vLLM 개념을 업스테이지의 모델에 접목해 자격 검증(PoC)을 진행해 성공하기도 했다.

김홍석 CSA는 “업스테이지의 LLM 모델에 적응하여 자격 검증을 마치고 상용 서비스를 준비 중”이라며 “vLLM은 네이버에서도 연내 오픈소스로 공개할 예정이며, 파이토치 개발 주역이 설립한 파이어웍스AI(Fireworks AI) 역시 이 기술을 쓰고 있다”고 전했다.

파이어웍스AI는 기업들이 생성형 AI 모델을 맞춤형으로 배치하거나 파인튜닝할 수 있도록 지원하는 AI 스타트업이다. 이 회사는 지난 7월 세콰이어 캐피털, 엔비디아, AMD, 몽고DB 등으로부터 5200만 달러(한화 약 710억 원) 규모의 시리즈 B 투자를 유치했으며, 당시 회사 가치는 약 5억 2200만 달러(약 6857억 원)로 평가받았다.

[김홍석 리벨리온 CSA 약력]△University of Illinois, Urbana-Champaign(UIUC), Computer Science 박사 - 서울대학교 전기공학부 학사

△Chief Software Architect (2024.05~) - Engineering Director & Google Korea Site Lead, Google - Software Engineer, Facebook - Software Engineer, Microsoft - Management Consultant, Bain & Company

![[포토] 최혜진 '우승이 필요해~'](https://spnimage.edaily.co.kr/images/Photo/files/NP/S/2024/11/PS24110600136t.jpg)

![[포토] 농협, '쌀밥의 오해와 진실' 주제발표](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/11/PS24110601352t.jpg)

![[포토]더본코리아 코스피 상장](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/11/PS24110601006t.jpg)

![[포토] CBDC 실증 협약식](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/11/PS24110600981t.jpg)

![[포토]주식시장 활성화 TF 1차회의, '발언하는 진성준 정책위의장'](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/11/PS24110600959t.jpg)

![[포토] CBDC 실증 MOU](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/11/PS24110600943t.jpg)

![[포토]국방·외교 현안관련 긴급 점검회의, '발언하는 한동훈'](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/11/PS24110600910t.jpg)

![[포토]이재명-박찬대, '어떤 대화 나누나?'](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/11/PS24110600745t.jpg)

![[포토]제시 린가드, 'VIP 시사회 출전'](https://spnimage.edaily.co.kr/images/Photo/files/NP/S/2024/11/PS24110500161t.jpg)

![[포토]서울시, 서리풀 공공주택지구 추진](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/11/PS24110501121t.jpg)

![[포토] 황유민 '이번주 대회 많관부 부탁해요~'](https://spnimage.edaily.co.kr/images/vision/files/NP/S/2024/11/PS24110600142h.jpg)